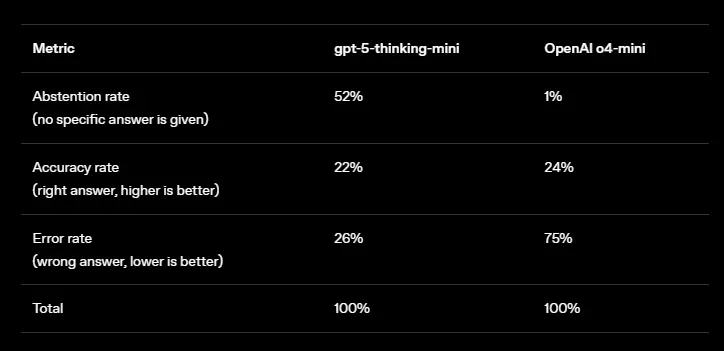

# 恐怖は目を大きくさせるあなたはどれくらいの頻度で、全能の人工知能が主役を務める世界の終わりについての予言を耳にしますか?少なくとも週に一度は、あるビジネスマンや有名人が、その恐ろしい未来についての懸念を口にしています。もちろん、有名人と陰鬱な予測の組み合わせは、大きな見出しを飾るための完璧なレシピです。しかし、かつてこの手法で作られたコンテンツは、しばしば技術の実際の進歩や時には恐怖を伴う進展を反映していましたが、今ではそれはむしろ空虚なマーケティングや単なる理解不足を思わせることが多くなっています。なぜ私たちは、現代のチャットボットが平然と嘘をつき、五行の対話さえ記憶できないのに、「ターミネーター」の悪い再話にまだ怯えるのでしょうか?そして最も重要なことは、それが誰にとって利益になるのかということです。## 印象に残らないまず最初に言っておきたいのは、AI技術は過去10年で大きな飛躍を遂げたということです。現代のシステムは、つながりのある文章を書き、大量のデータのパターンを認識し、ビジュアルコンテンツを作成できるようになっています。つい最近まで、機械は人間の労働をこれほどまでに代替できませんでした。進歩の見通しは確かに恐ろしいものです。しかし、現時点では、大規模な製品の開発は、いわゆる汎用人工知能やほぼ同じような言語モデルのリリースにとどまっています(時には新モデルの方が旧モデルより劣ることさえあります)。結局のところ、私たちが持っているのは、テキストや時には画像を扱う簡単なタスクをこなすために訓練されたツールです。人々はこれをV字コーディングやSNSの投稿作成に利用しています。ただし、その結果はしばしば再確認を要し、より複雑な作業にはニューラルネットは対応できません。今あなたが好きなチャットボットに、「Xについての博士論文を書いて」と頼むと、検索エンジンの一ページ目または二ページ目のリンク付きで、意味的にまとまりのない文章が返ってきます。結果を改善するために拡張されたプロンプトを使うことも推奨されますが、それは単に「機械言語」への微調整や追加学習に過ぎません。長期間AIを使い続けると、誰もが今日のモデルの限界を認識するようになるでしょう。結局、進歩は学習用データベースの容量とサーバーの処理能力に行き着き、「知性」の要素は二の次になっています。## 脳のない知性コンテキストを理解するためには、AIの仕組みを説明する必要があります。簡単に言えば、従来型チャットボットの大規模言語モデル(LLM)は次のように動きます。1. 入力されたテキストはトークン(単語の一部や記号)に分割される。2. 各トークンに数値ベクトルが割り当てられる。3. モデルはトークン間の関係性を分析し、文脈理解に最も重要な語を特定する。4. その上で、LLMは次に来るトークンを「予測」し、回答を形成する。「予測」するのは、空からではありません。これには、事前にインターネット上の公開情報を中心とした巨大なデータベースで学習を済ませており、その情報から「知性」を引き出しています。言語モデルは、人間の意味で「理解」しているわけではなく、統計的なパターンを計算しているに過ぎません。現代の主要なチャットボットは、すべて「トランスフォーマー」と呼ばれる基本的なアーキテクチャを共有し、この原理に基づいて動いています。もちろん、これは大雑把な比較ですが、LLMは巨大なデータベースを基にした非常に強力な計算機と呼べます。多くの側面で私たちの生活を便利にする強力なツールですが、その「知性」と呼べるものを持つにはまだ早すぎます。現代のチャットボットは、むしろGoogleのGeminiのような新しい検索エンジンの進化版に近く、ポケットの中の万能アシスタントというよりは、次第に進化した検索ツールに見えます。さらに、AIの回答の信頼性には疑問も残ります。神経ネットの幻覚や嘘の統計が明らかになると、やはり「ググる」方が確実だと感じる人も多いでしょう。GPT-5とo4-miniの回答精度比較。出典:OpenAI.## びっくりした?終末論者の主張の核心は、「AIは指数関数的に賢くなる」ため、いずれ人間の知性を超えたとき、人類は終わるというものです。確かに、現代のAIは、データ処理や変換の正確さにおいて私たちを凌駕しています。例えば、ニューラルネットは「ウィキペディア」をかなり詳細に要約できるほどです。しかし、それ以上の知識はほぼ持ち得ません。正確には、モデルはそれらを「個人的な目的」に使うことはできず、その必要もないからです。また、すでに判明しているのは、人工知能は私たちの周囲の世界を理解していないということです。物理法則は、AIにとっては闇の森です。言語モデルの進化は、予測(トークンの推測)の範囲拡大にとどまっています。しかし、AIはテキスト学習の限界に近づいており、ますます「空間的」な知性の創出が必要だとの声も高まっています。しかし、技術の弱点は見極められることもありますし、その研究も進んでいます。一方、より複雑な問題は未解決のままです。人類にとっても、多くの脳の仕組みは未解明です。ましてや、その複雑な構造をデジタル空間で再現することは、なおさら難しい課題です。さらに、AIのほぼ克服できない障壁の一つは、創造性です。新しいものを生み出す能力です。LLMは、技術的には既存のデータの再処理に基づいているため、自らのアーキテクチャの制約を超えることはできません。したがって、AIの未来は、どの情報を人類が投入するかに大きく依存します。現状では、すべての学習資料は人間の利益のために設計されています。公平を期すために言えば、イーロン・マスクと彼のGrokも挙げておくべきです。ある時、ユーザーはチャットボットの偏見や、億万長者の能力を過大評価する傾向に気づきました。これは倫理的にかなり問題のある兆候ですが、潜在的な「神経イーロン」が人類に物理的に害を及ぼす可能性は低いでしょう。結局のところ、人工知能の唯一の目的は、ユーザーのリクエストに従うことです。チャットボットには意志や自己の欲求はなく、今後もそのパラダイムは変わらないと考えられます。## 恐怖の解剖では、なぜ私たちは今もなお、「あまり賢くない」発明品であるAIに怯えるのでしょうか?その主な答えは表面にあります。技術の理解不足を除けば、最も単純な理由は金銭や人気への貪欲さです。例として、「終末予言者」の一人、エリザベス・ユドコウスキーのケースを見てみましょう。AI研究者であり、「もし誰かがそれを作れば、皆死ぬ」という著書の共著者は、2000年代から超知能AIについて警告しています。人間の価値観から乖離した超知能の出現を予見しているのです。書籍の表紙。出典:Instaread。「超知能」の出現はまだ見えませんが、ユドコウスキー自身もそれを認めています。しかし、それにもかかわらず、彼は大きな声で警鐘を鳴らし、書籍を売っています。有名な物理学者であり、「AIの教父」と呼ばれるジェフリー・ヒントンもまた、黙示的な危険性について言及しています。彼は、技術が進歩すれば、今後30年以内に人類絶滅の可能性が10-20%になると評価しています。ヒントンによると、能力が向上するにつれて、「人工知能を制御下に置く」戦略は通用しなくなる可能性があり、エージェントシステムは生存と支配拡大を目指すようになると考えています。この場合、誰が何のためにAIに「生きる意志」を与えるのかは不明です。ヒントンは引き続きニューラルネットの研究を続けており、2024年にはその業績でノーベル賞にノミネートされ、2026年初頭には、サイバネティクスのヨシュア・ベンジオに次ぐ史上2人目の100万引用を達成しました。驚くべきことに、より現実的な見解を示すのは、Google Brainの共同創設者アンドリュー・ングです。彼は人工知能を「非常に限定的な」技術と呼び、近い将来、アルゴリズムが人間に取って代わることはないと断言しています。明らかに、どの分野にも鋭い予言者は存在しますし、AI業界においても、彼らの存在はSFへの大きな愛情の証とも言えます。誰しも、フィリップ・ディックやロバート・シェクリのような物語で神経を刺激したいと思うもので、その物語が現実の中で展開されるのを望むのです。こうした状況では、大手企業の発言も多くの疑問を呼びます。彼らはさも当然のように、雇用の脅威やAIの急速な発展を警告しています。二つ目の主張は、多くの場合コスト削減の必要性に由来しますが、一方で最初の主張は、より陰謀論的な解釈を誘発します。例えば、世界最大級の企業の一つ、アマゾンは過去半年で3万人以上の従業員を解雇しました。経営陣は、最適化計画や自動化の推進、AI導入を理由としています。倉庫ロボットの開発も継続していますが、悪意のある見方では、その背景にはパンデミック時代の人事管理の失敗があると指摘されています。アマゾンだけでなく、シリコンバレーのAI企業は従業員数を増やし続け、新たなオフィスを借りています。それと同時に、2023年にはほぼ同じ企業群が、AIの発展を抑制すべきだとする「AI安全性センター」の声明に署名しました。そこでは、人工知能はパンデミックや核戦争と同じくらい「存在論的リスク」をもたらすと警告しています。AI安全性センターの声明。出典:aistatement.com. 時とともにこの声明は忘れられ、研究は続けられましたが、明確な脅威は現れませんでした。企業的な見地から言えば、過熱したAIバブルの時代において、技術的変化を理由にする方が、人的資源管理の構造的な問題を認めるよりも都合が良いのです。しかし、そのような発言は、実際の問題—誤情報やディープフェイク—から目をそらさせる危険もあります。人工知能は雇用を奪うのではなく、働き方を変えるものであり、場合によっては仕事を簡素化します。ただし、ハーバードの小規模調査では、逆にAIが作業を複雑にし、遅らせるケースもあることが示されています。この技術は確実に私たちの生活のあらゆる分野に浸透していきます。教育、科学、商取引、政治などです。しかし、それがどのような形で現れるかは、最終的には人間次第です。今のところ、ニューラルネットには「声を持つ」権利はありません。## 私たちには届かない前述したのは、チャットボットや生成系の「絵描き」などの一般公開されているAIについてです。もちろん、閉ざされた扉の向こうには、より高度な開発も存在します。比較的簡単な例としては、医療や考古学の分野のLLMがあります。例えば、新しいタンパク質の合成を支援したり、古代の文書を解読したりするものです。しかし、そのような研究やテスト、リリースの結果は、アクセスしにくい内部レポートや専門的なメディアの報告を通じてしか知ることができず、その情報の把握はほぼゼロに近いです。ただし、今まさにこの分野で最も大きなブレイクスルーが起きている可能性は高いです。おそらく、「終末の日のAIマシン」が、閉鎖的な研究所から出現することはないでしょう。これらはすべて特定の目的に特化したモデルであり、必要なことだけを行います。AIの制御不能の懸念は、私たち自身の恐怖の反映にすぎません。仕事を失うことや、倫理的な問題の複雑さなどです。しかし、私たち人間が未来の技術の方向性や目的を決めている間は、AIはあくまで道具であり、自己意志を持つ主体ではありません。潜在的なリスクについて語るのは正しいことです。黙示録的な理論を空想するのも人間の性です。ただし、そのような話には常に懐疑的な目を向けるべきです。もし「オフ」ボタンが手元にあるなら、私たちの世界に超知能の脅威は訪れません。*ヴァシリー・スミルノフ*

恐怖の目は大きい - ForkLog: 暗号通貨、AI、シンギュラリティ、未来

あなたはどれくらいの頻度で、全能の人工知能が主役を務める世界の終わりについての予言を耳にしますか?少なくとも週に一度は、あるビジネスマンや有名人が、その恐ろしい未来についての懸念を口にしています。

もちろん、有名人と陰鬱な予測の組み合わせは、大きな見出しを飾るための完璧なレシピです。しかし、かつてこの手法で作られたコンテンツは、しばしば技術の実際の進歩や時には恐怖を伴う進展を反映していましたが、今ではそれはむしろ空虚なマーケティングや単なる理解不足を思わせることが多くなっています。

なぜ私たちは、現代のチャットボットが平然と嘘をつき、五行の対話さえ記憶できないのに、「ターミネーター」の悪い再話にまだ怯えるのでしょうか?そして最も重要なことは、それが誰にとって利益になるのかということです。

印象に残らない

まず最初に言っておきたいのは、AI技術は過去10年で大きな飛躍を遂げたということです。現代のシステムは、つながりのある文章を書き、大量のデータのパターンを認識し、ビジュアルコンテンツを作成できるようになっています。つい最近まで、機械は人間の労働をこれほどまでに代替できませんでした。

進歩の見通しは確かに恐ろしいものです。しかし、現時点では、大規模な製品の開発は、いわゆる汎用人工知能やほぼ同じような言語モデルのリリースにとどまっています(時には新モデルの方が旧モデルより劣ることさえあります)。

結局のところ、私たちが持っているのは、テキストや時には画像を扱う簡単なタスクをこなすために訓練されたツールです。人々はこれをV字コーディングやSNSの投稿作成に利用しています。ただし、その結果はしばしば再確認を要し、より複雑な作業にはニューラルネットは対応できません。

今あなたが好きなチャットボットに、「Xについての博士論文を書いて」と頼むと、検索エンジンの一ページ目または二ページ目のリンク付きで、意味的にまとまりのない文章が返ってきます。結果を改善するために拡張されたプロンプトを使うことも推奨されますが、それは単に「機械言語」への微調整や追加学習に過ぎません。

長期間AIを使い続けると、誰もが今日のモデルの限界を認識するようになるでしょう。結局、進歩は学習用データベースの容量とサーバーの処理能力に行き着き、「知性」の要素は二の次になっています。

脳のない知性

コンテキストを理解するためには、AIの仕組みを説明する必要があります。簡単に言えば、従来型チャットボットの大規模言語モデル(LLM)は次のように動きます。

「予測」するのは、空からではありません。これには、事前にインターネット上の公開情報を中心とした巨大なデータベースで学習を済ませており、その情報から「知性」を引き出しています。

言語モデルは、人間の意味で「理解」しているわけではなく、統計的なパターンを計算しているに過ぎません。現代の主要なチャットボットは、すべて「トランスフォーマー」と呼ばれる基本的なアーキテクチャを共有し、この原理に基づいて動いています。

もちろん、これは大雑把な比較ですが、LLMは巨大なデータベースを基にした非常に強力な計算機と呼べます。多くの側面で私たちの生活を便利にする強力なツールですが、その「知性」と呼べるものを持つにはまだ早すぎます。

現代のチャットボットは、むしろGoogleのGeminiのような新しい検索エンジンの進化版に近く、ポケットの中の万能アシスタントというよりは、次第に進化した検索ツールに見えます。

さらに、AIの回答の信頼性には疑問も残ります。神経ネットの幻覚や嘘の統計が明らかになると、やはり「ググる」方が確実だと感じる人も多いでしょう。

終末論者の主張の核心は、「AIは指数関数的に賢くなる」ため、いずれ人間の知性を超えたとき、人類は終わるというものです。

確かに、現代のAIは、データ処理や変換の正確さにおいて私たちを凌駕しています。例えば、ニューラルネットは「ウィキペディア」をかなり詳細に要約できるほどです。しかし、それ以上の知識はほぼ持ち得ません。正確には、モデルはそれらを「個人的な目的」に使うことはできず、その必要もないからです。

また、すでに判明しているのは、人工知能は私たちの周囲の世界を理解していないということです。物理法則は、AIにとっては闇の森です。

言語モデルの進化は、予測(トークンの推測)の範囲拡大にとどまっています。しかし、AIはテキスト学習の限界に近づいており、ますます「空間的」な知性の創出が必要だとの声も高まっています。

しかし、技術の弱点は見極められることもありますし、その研究も進んでいます。一方、より複雑な問題は未解決のままです。

人類にとっても、多くの脳の仕組みは未解明です。ましてや、その複雑な構造をデジタル空間で再現することは、なおさら難しい課題です。

さらに、AIのほぼ克服できない障壁の一つは、創造性です。新しいものを生み出す能力です。LLMは、技術的には既存のデータの再処理に基づいているため、自らのアーキテクチャの制約を超えることはできません。

したがって、AIの未来は、どの情報を人類が投入するかに大きく依存します。現状では、すべての学習資料は人間の利益のために設計されています。

公平を期すために言えば、イーロン・マスクと彼のGrokも挙げておくべきです。ある時、ユーザーはチャットボットの偏見や、億万長者の能力を過大評価する傾向に気づきました。これは倫理的にかなり問題のある兆候ですが、潜在的な「神経イーロン」が人類に物理的に害を及ぼす可能性は低いでしょう。

結局のところ、人工知能の唯一の目的は、ユーザーのリクエストに従うことです。チャットボットには意志や自己の欲求はなく、今後もそのパラダイムは変わらないと考えられます。

恐怖の解剖

では、なぜ私たちは今もなお、「あまり賢くない」発明品であるAIに怯えるのでしょうか?その主な答えは表面にあります。

技術の理解不足を除けば、最も単純な理由は金銭や人気への貪欲さです。

例として、「終末予言者」の一人、エリザベス・ユドコウスキーのケースを見てみましょう。AI研究者であり、「もし誰かがそれを作れば、皆死ぬ」という著書の共著者は、2000年代から超知能AIについて警告しています。人間の価値観から乖離した超知能の出現を予見しているのです。

有名な物理学者であり、「AIの教父」と呼ばれるジェフリー・ヒントンもまた、黙示的な危険性について言及しています。彼は、技術が進歩すれば、今後30年以内に人類絶滅の可能性が10-20%になると評価しています。

ヒントンによると、能力が向上するにつれて、「人工知能を制御下に置く」戦略は通用しなくなる可能性があり、エージェントシステムは生存と支配拡大を目指すようになると考えています。

この場合、誰が何のためにAIに「生きる意志」を与えるのかは不明です。ヒントンは引き続きニューラルネットの研究を続けており、2024年にはその業績でノーベル賞にノミネートされ、2026年初頭には、サイバネティクスのヨシュア・ベンジオに次ぐ史上2人目の100万引用を達成しました。

驚くべきことに、より現実的な見解を示すのは、Google Brainの共同創設者アンドリュー・ングです。彼は人工知能を「非常に限定的な」技術と呼び、近い将来、アルゴリズムが人間に取って代わることはないと断言しています。

明らかに、どの分野にも鋭い予言者は存在しますし、AI業界においても、彼らの存在はSFへの大きな愛情の証とも言えます。誰しも、フィリップ・ディックやロバート・シェクリのような物語で神経を刺激したいと思うもので、その物語が現実の中で展開されるのを望むのです。

こうした状況では、大手企業の発言も多くの疑問を呼びます。彼らはさも当然のように、雇用の脅威やAIの急速な発展を警告しています。二つ目の主張は、多くの場合コスト削減の必要性に由来しますが、一方で最初の主張は、より陰謀論的な解釈を誘発します。

例えば、世界最大級の企業の一つ、アマゾンは過去半年で3万人以上の従業員を解雇しました。経営陣は、最適化計画や自動化の推進、AI導入を理由としています。

倉庫ロボットの開発も継続していますが、悪意のある見方では、その背景にはパンデミック時代の人事管理の失敗があると指摘されています。

アマゾンだけでなく、シリコンバレーのAI企業は従業員数を増やし続け、新たなオフィスを借りています。

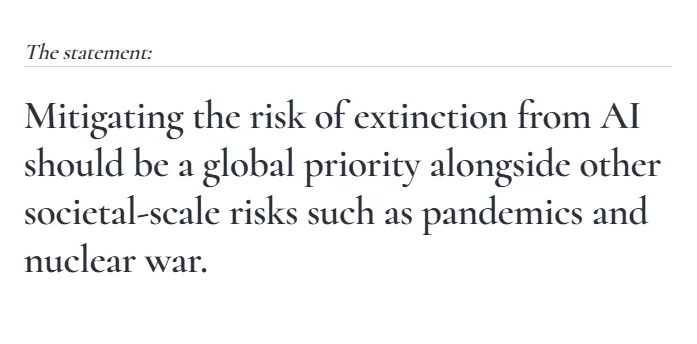

それと同時に、2023年にはほぼ同じ企業群が、AIの発展を抑制すべきだとする「AI安全性センター」の声明に署名しました。そこでは、人工知能はパンデミックや核戦争と同じくらい「存在論的リスク」をもたらすと警告しています。

企業的な見地から言えば、過熱したAIバブルの時代において、技術的変化を理由にする方が、人的資源管理の構造的な問題を認めるよりも都合が良いのです。しかし、そのような発言は、実際の問題—誤情報やディープフェイク—から目をそらさせる危険もあります。

人工知能は雇用を奪うのではなく、働き方を変えるものであり、場合によっては仕事を簡素化します。ただし、ハーバードの小規模調査では、逆にAIが作業を複雑にし、遅らせるケースもあることが示されています。

この技術は確実に私たちの生活のあらゆる分野に浸透していきます。教育、科学、商取引、政治などです。しかし、それがどのような形で現れるかは、最終的には人間次第です。今のところ、ニューラルネットには「声を持つ」権利はありません。

私たちには届かない

前述したのは、チャットボットや生成系の「絵描き」などの一般公開されているAIについてです。もちろん、閉ざされた扉の向こうには、より高度な開発も存在します。

比較的簡単な例としては、医療や考古学の分野のLLMがあります。例えば、新しいタンパク質の合成を支援したり、古代の文書を解読したりするものです。

しかし、そのような研究やテスト、リリースの結果は、アクセスしにくい内部レポートや専門的なメディアの報告を通じてしか知ることができず、その情報の把握はほぼゼロに近いです。ただし、今まさにこの分野で最も大きなブレイクスルーが起きている可能性は高いです。

おそらく、「終末の日のAIマシン」が、閉鎖的な研究所から出現することはないでしょう。これらはすべて特定の目的に特化したモデルであり、必要なことだけを行います。

AIの制御不能の懸念は、私たち自身の恐怖の反映にすぎません。仕事を失うことや、倫理的な問題の複雑さなどです。しかし、私たち人間が未来の技術の方向性や目的を決めている間は、AIはあくまで道具であり、自己意志を持つ主体ではありません。

潜在的なリスクについて語るのは正しいことです。黙示録的な理論を空想するのも人間の性です。ただし、そのような話には常に懐疑的な目を向けるべきです。もし「オフ」ボタンが手元にあるなら、私たちの世界に超知能の脅威は訪れません。

ヴァシリー・スミルノフ